Hallo,

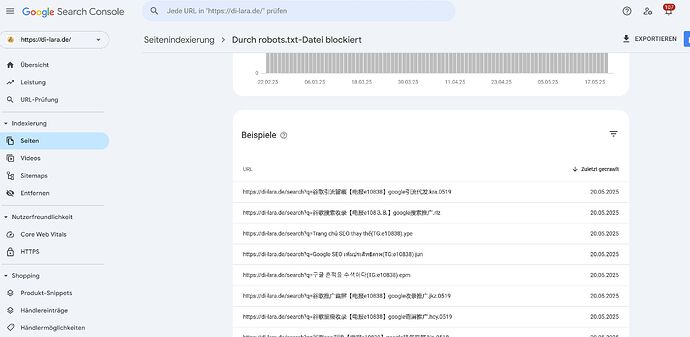

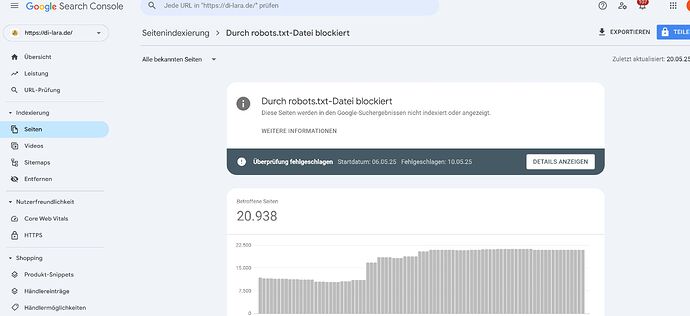

seit einiger Zeit mehren sich bei uns Seiten, die durch robot.txt Datei blockiert werden. Es handelt sich meistens, um Seiten, die auf Search mit asiatischen Schriften verweisen (siehe Bilder):

Wir haben bisher über Backlink-Analyse und Disavow-Tool versucht, diese negativen Links im Griff zu bekommen, aber vergeblich. Es kommen alle 3-4 Tage mehrere Seiten wieder rein.

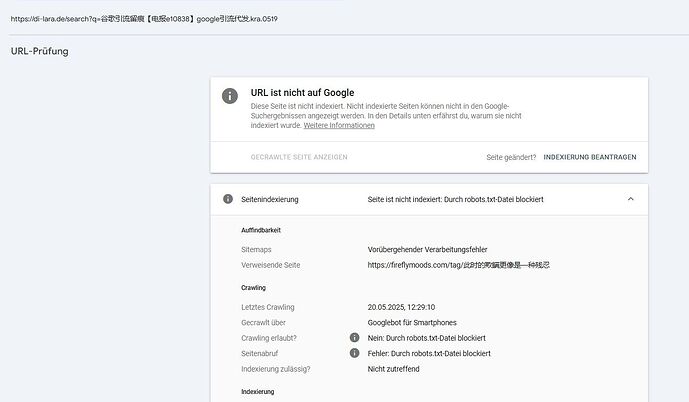

Hier ein Bild, das eines der Links anzeigt, die von Google nicht gefunden werden:

Ich hoffe, jemand hat eine Idee, wie wir das Problem im Griff bekommen und dadurch die Seite in der Sichtbarkeit wieder besser steht.

DANKE